眼球追踪在部分商用场景已经得到应用,这是一项价值潜力极大技术。目前,主流的非近眼的眼球追踪方案来自于Tobii等,其往往需要专业的硬件设备,价格也相对昂贵,普及尚存一定障碍。

近眼显示领域的眼球追踪方案,例如Tobii在AR、VR眼镜提供的方案,不过它仍需要高度集成的硬件。虽然目前可实现更高度的集成效果,最新Tobii Pro Glasses 3可以做到和普通眼镜大小、厚度类似,能实现高精度眼球追踪方案,未来值得期待。

在近眼显示领域,眼球追踪技术的优势很多:增强AR/VR交互,令交互更自然;提供了全新的内容玩法;优化显示效果,提升显卡渲染的利用率;提供热力图追踪,进行辅助视觉判断等等。

而在非近眼的眼球追踪领域,例如手机、平板、电脑、汽车等更多场景中,眼球追踪可以发挥不同的作用,例如给PC游戏提供新的交互玩法,在智能手机或PC进行视频通话时,可以进行眼球视角的纠正;在汽车场景中,实现疲劳驾驶提醒等。

当然,眼睛作为人类交互的重要方式之一,在微动作、微表情等心理研究,医疗健康、在线教育等领域同样有极大应用潜力。

基于AI、不受硬件限制

除了基于专业硬件的眼球追踪方案外,基于软件简易化或便民的眼球追踪方案也有一些,它们往往通过低价取胜,应用在一些精准度要求不高的场景中。但是,这些方案往往特别容易受光线所影响,一旦光线复杂或环境光低就会影响追踪效果。

近期,微软雷德蒙德研究院在Arxiv发布预印论文《面向广泛硬件的AI眼球追踪方案》(Towards Hardware-Agnostic Gaze-Trackers)。

在论文中,就明确提出了一套基于AI的、不受硬件限制的、且不易受光线环境影响眼球追踪方案。

这套方案特点是:完全可基于手机、PC的摄像头,而这些摄像头均为非高精设备。

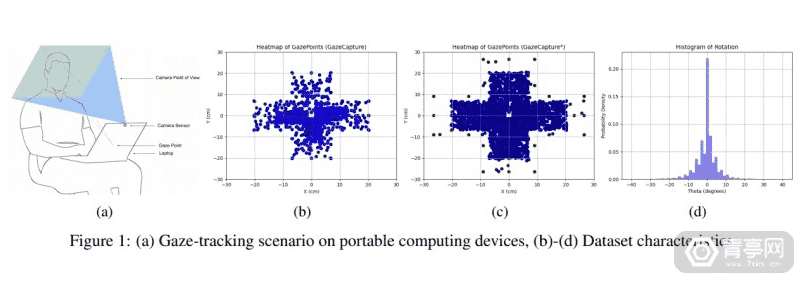

实际上,这项论文的基础来自于MIT iTracker的GazeCapture研究项目,这是基于AI眼球追踪模型,其可运行在苹果设备中,该研究在未经校准情况下,于iPhone和iPad中的误差分别为1.86cm和2.81cm。

而微软的目标则是,让这套系统可以在智能手机和平板电脑之外的设备上使用,例如在PC中实现类似鼠标的操作。

微软的方案在已公布的MIT语料库GazeCapture中测试误差为1.8073cm,并已经集成了1450人的眼球追踪数据,可以做到无需校准或微调即可使用。

细节方面,微软研究员将左眼、右眼、面部作为输入数据,使用25×25像素面部网格,基于ResNet18进行子模型分析训练。

为了更好的满足显示环境中复杂的光线环境,微软研究员还会随机更改图像亮度、对比度、饱和度、色调等,并随机裁剪大小,增加噪点,从而防止模型过度拟合。

然后再将此模型和人脸检测库Dlib结合,从而可以实现GazeCapture不支持的眉毛和唇部动作数据,进一步实现面部轮廓数据的整合,包括面部微动作、眼睛动作。最终,通过这些数据消除误差。

其中发现了一个特性,当人眼看向特定区域时,面部肌肉就会呈现特定动作,这里综合眉毛和唇部动作就可以实现更精准的追踪,从而提升精准度。

当然,目前这一研究也存在一些问题,例如面部一旦遇到遮挡,就会影响精准度等。但未来随着数据量的提升,目标无疑是在手机、平板、PC等广泛的电子消费产品中得到广泛应用。

类似应用或玩法

实际上,微软在眼球追踪和身份验证方面一直有研究,例如在Windows 10中提供的Windows Hello中的面部、虹膜等解锁方案,并且Windows 10也是第一个系统级别眼动控制的操作系统版本。

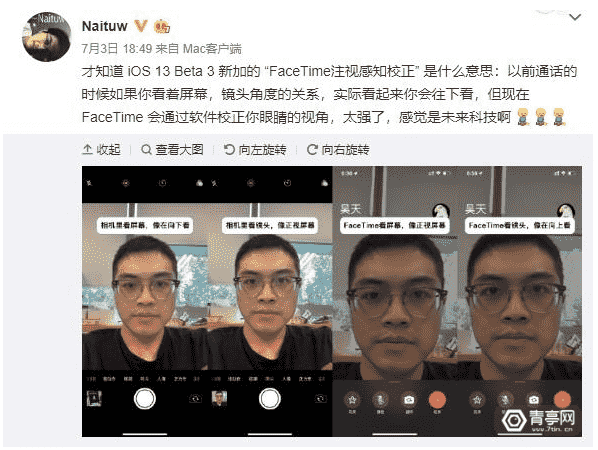

例如,苹果ARKit 3中就提供了FaceTime注视感知校正功能。手机的前置镜头当你看着屏幕时,眼睛注视区实际是向下的,因为摄像头在屏幕上方。当然如果你看摄像头拍照你的眼睛注视才是正常的盯着屏幕看。而在视频通话中,如果你看着屏幕,而对方认为你注意力不在,那会是一件不礼貌的事情。

为此,苹果在FaceTime视频通话中就改善了这一问题:即使你盯着屏幕看也没事,ARKit 3会自动将你的眼睛注视方向调整为正常视角,虽然你看的是屏幕,但是对方看到的你跟“看向摄像头”视角是相同的。

目前该功能仅在A12和A12X,且具备前置TrueDepth原深感相机的设备中运行。

来源:青亭网