此前我们报道大量苹果、微软等相关专利,从中我们或多或少了解一些产品信息,但关于AR眼镜(消费级)的未来仍然没有一个明确答案,而这个过程,可能会比VR(2014年Oculus首个VR产品走向大众,到2020年VR有大众化的普及趋势)更久。

今天,我们就从其中一点来看,那就是AR中的人脸识别,本文作者是BivásBiswas,他是可视化公司Zoic Labs的高级工程师,他在文章中提出了几个观点:

LiDAR开启AR交互大门;

Reality Composer有望成为下一个iMovie;

AR中的锚点和真实物体相互依存。

1,为什么说LiDAR开启AR交互体验大门

苹果已经在2020年为iOS设备引入LiDAR传感器,虽然目前仅仅集中在Pro系列设备中,但是这依然让我们看到了AR交互的潜力。

LiDAR自身优势很广泛,在iPhone、iPad这类小型化设备上,做到了5米测距,意味着以中心为直径的10米的圆形内都可以被检测到,这满足了大多数室内场景。

BivásBiswas表示:LiDAR已经广泛应用到机器人等领域,它可以让机器人“了解”现实世界的环境,以及相对空间中的位置和方向等等。而你的手机可以看作是一个“没有机器臂的机器人”,但是它有核心处理能力,内置了一些传感器,而LiDAR就是最新型的传感器之一。

我们知道。人类通过双目视差的方式获取深度信息。而基于计算机双目视觉的、实时帧率计算方案成本则非常昂贵。LiDAR的出现,让我们可以通过LiDAR+单目视觉实现这些功能。

和以往只能拍摄2D照片不同,结合LiDAR后可以识别深度信息,甚至完成3D扫描工作,这已经是移动设备上很大的进步。因此,基于LiDAR就可以实现更复杂、更全面的AR内容。

当然,这里就需要一套更人性化的框架,它需要降低操作复杂性,抛开底层技术原理,可以方便地让开发者、设计师、艺术创作者等完成创作,降低开发难度和周期,提高开发效率。

2,Reality Composer有望成为下一个iMovie

iMovie是苹果公司官方的视频编辑应用,它的特点是可以更快、更轻松的完成视频剪辑工作,同时支持iOS、macos等平台。

回到iOS系统,它也应该拥有和iMovie相对应的AR编程框架,即ARKit、RealityKit。ARKit是整个AR平台的底层基础,用于处理IMU、LiDAR、视觉等数据信息,而RealityKit则是基于ARKit平台的内容创作框架。

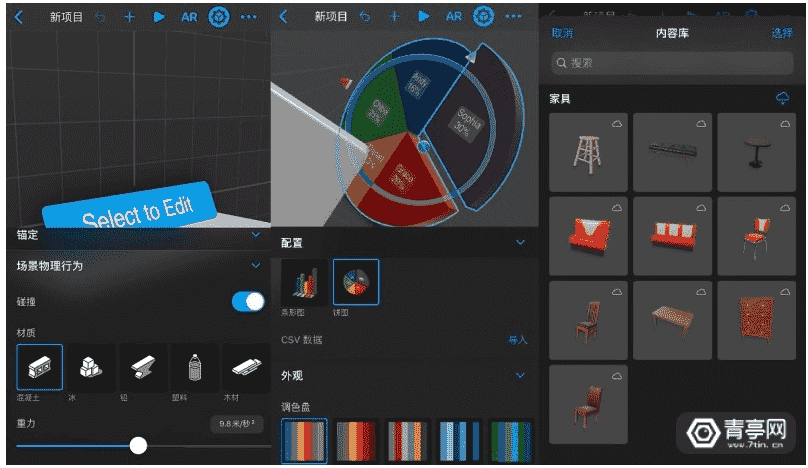

在RealityKit中(Reality Composer,伴随iOS 13.1系统发布一同上线),你可以进行各种各样的创作,它的特点就是让你通过你通过拖拽、点击等简单的操作即可构建可互动的AR场景,同时内置大量3D内容数据库,还可与Xcode和iOS应用配合使用,这样就能实现AR场景快速预览并进行微调,大幅提升效率。

Reality Composer不仅仅具备极佳的阴影、照明、环境反射效果,而且还深度打通USDZ,实现苹果整套开发工作的闭环,无疑不是让苹果在AR创作中更轻松。

当然,很多人也知道例如Unreal虚幻引擎、Unity、3DSMax、Maya等工具也可以完成这些创作,而且可以导出为USDZ格式进行交互。而苹果还在不遗余力地推动3D内容创作平台Reality Composer等等工作,BivásBiswas推测这可能是为自家Mac生态系统提供端到端的AR内容创作方案。

谈到Reality Composer的使用也非常轻松,它支持iOS和macOS双平台,在手机上你可以通过触屏缩放,拖拽进行轻量化的AR内容创作,而在Mac上则可以完成更复杂的场景和交互。

而在Mac开发需要实时调试,尤其是对于AR开发工作而言,这就凸显出了Reality Composer的重要性。因为基于强大的iCloud系统,可以让USDZ文件快速的在iPhone进行预览。

同时,苹果还在Safari浏览器中提供AR快速预览功能,只要是USDZ格式的文件,都可以在Safari浏览器进行快速预览,这也是苹果在AR生态构件中的重要一环。

3,AR中锚点和实物互相依存

我们知道,AR交互的重要工作是虚拟对象和真实世界像交互,而不是像谷歌眼镜中那样虚拟图像会跟随头的方向转来转去,这其中的关键技术就是锚点固定。

也就是说,计算机生成的CG虚拟图像,需要实时锚定在显示物体之中,为此AR系统后台不得不实时追踪摄像头数据,并且对每帧数据进行锚点更新。这其中涉及到ARFrame,它包含了摄像头、锚点、场景、追踪、映射状态、地址位置等信息。

实际上,任何的虚拟物体(3D模型)都可以和锚点绑定,大到宇宙飞船,小到一个玻璃球。将虚拟物体锚定后,AR系统将对其进行深度追踪,即便你继续前后左右的移动,虚拟物体将保持固定在那里,就像是真实世界中的物体一般。

当ARKit检测到人脸后,它会将锚点放置于鼻子后方(这是一个人眼不可见的区域),该锚点称为ARFaceAnchor,也经常用于前置摄像头用于人脸检测。

ARFaceAnchor可以完成:眼睛追踪、眼球追踪、眉毛、颌骨等面部信息的追踪,从而实现更好的面部AR交互效果,而这就是ARFaceGeometry属性。

ARFaceGeometry的出现让3D虚拟物体的面部互动成为可能,例如苹果Animoji。而基于此,还可以完成AR美妆、甚至虚拟太阳镜等等交互和玩法,和Snapchat的玩法差不多,只不过Snap应用了自己的开发平台,而不是ARKit。

由此可知,在AR中实现追踪并不是一件易事,一方面需要拥有更为强大的传感器,另一方面还需要设备有足够的算力。就现阶段而言,移动AR体验过程中,锚点不可避免地会有偏移,不仅仅是ARKit系统、就连HoloLens、Magic Leap也是如此,不同的设备偏移差也有所不同,但拥有完善的SLAM能力的AR头显效果相对更好一些。

无论如何,在移动设备上引入LiDAR是一个大的飞跃,它可以获取环境3D信息,对虚拟对象实现更好的锚定和追踪等。Reality Composer同样具有极大潜力,综合所有追踪、锚点等技术,希望这些技术能够成为开发出优质AR应用的好工具。

来源:青亭网